微軟開放AI系統工具Counterfit源代碼 助力測試AI和機器學習系統安全性

近日,微軟開源了 AI 安全風險評估工具 Counterfit,該工具旨在幫助開發人員測試 AI 和機器學習系統的安全性。該公司表示,Counterfit 可以使組織進行評估,以確保其業務中使用的算法是可靠和可信賴的。

當前,人工智能技術正越來越多地應用在醫療,金融和國防等受監管的行業中。但是,組織在采用風險緩解策略方面處于落后狀態。一個微軟的調查發現,部分企業用戶表示,他們沒有合適的資源,以確保他們的 AI 系統的穩定性和安全性。

微軟表示,Counterfit 誕生于該公司評估 AI 系統是否存在漏洞的需求,目的是主動保護 AI 服務。該工具起初是專門為目標 AI 模型編寫的攻擊腳本集,然后演變為自動化產品以對多個系統進行大規模基準測試。

在底層,Counterfit 是一個命令行實用程序,為對抗性框架提供了一層,并預先加載了可用于逃避和竊取模型的算法。Counterfit 尋求使安全社區可以訪問已發布的攻擊,同時提供一個界面,通過該界面可以構建,管理和發起模型攻擊。

當使用 Counterfit 在 AI 系統上進行滲透測試時,安全團隊可以選擇默認設置,設置隨機參數或自定義每個參數以覆蓋廣泛的漏洞。具有多個模型的組織可以使用 Counterfit 的內置自動化功能進行掃描,并可以選擇多次掃描,以創建操作基準。

Counterfit 還提供日志記錄以記錄針對目標模型的攻擊。正如微軟指出的那樣,遙測技術可能會促使工程團隊提高對系統故障模式的了解。

在內部,微軟將 Counterfit 用作其 AI 紅色團隊運營的一部分,并在 AI 開發階段中使用,以在漏洞投入生產之前發現漏洞。該公司還表示,它已經與多家客戶進行了 Counterfit 的測試,其中包括航空航天巨頭空客公司(Airbus),該公司正在開發基于 Azure AI 服務的 AI 平臺。

“人工智能在工業中的使用越來越多”。空客公司高級網絡安全研究員 Matilda Rhode 在一份聲明中說:“確保這種技術的安全至關重要,特別是要了解在問題空間中可以在何處實現特征空間攻擊。”

基本上,企業希望人們相信 AI 是不受操縱,是安全的。1 月發布的 Gartner 的“管理 AI 風險的 5 大優先事項”框架中的一項建議是,組織“ 針對攻擊性攻擊采取特定的 AI 安全措施,以確保抵抗和復原力。”這家研究公司估計,到 2024 年,實施專門的 AI 風險管理控制的組織將避免負面的 AI 結果的發生頻率是未消除負面結果的兩倍。”

根據 Gartner 的一份報告,到 2022 年,所有 AI 網絡攻擊中有 30%將利用訓練數據中毒,模型盜竊或對抗性樣本攻擊以機器學習為動力的系統

責任編輯:hnmd003

相關閱讀

-

微軟開放AI系統工具Counterfit源代碼 助力測試AI和機器學習系統安全性

近日,微軟開源了 AI 安全風險評估工具 Counterfit,該工具旨在幫助開發人員測試 AI 和機器學習系...

2021-05-06 -

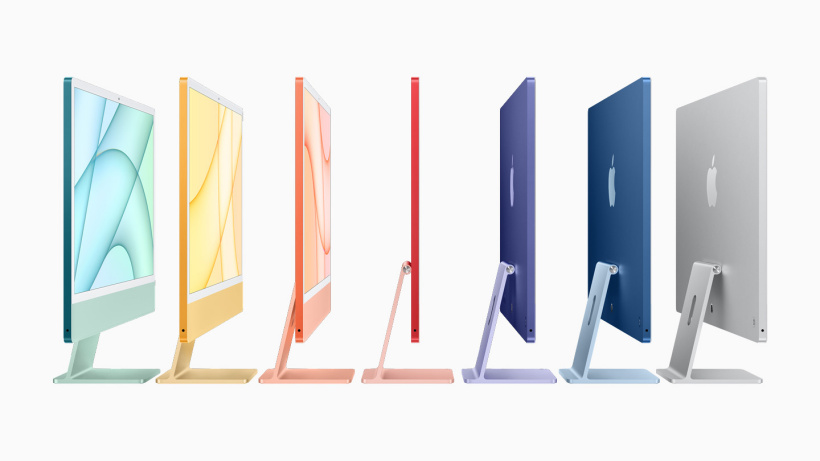

消息稱:蘋果有望憑借iMac電腦超越惠普 成為PC一體機銷量冠軍

據臺媒 Digitimes,基于市場數據預測,蘋果有望憑借新發布的 iMac 電腦,成為 PC 一體機銷量的最新...

2021-05-06 -

芯片短缺下蘋果iPad出貨量將保持穩定 iPad Pro或出現供應短缺

外媒 MacRumors 報道,持續的集成電路芯片短缺是由全球疫情危機期間出現的供應鏈問題和與天氣有關的事...

2021-05-05